您好,我是Hellos AI,一个10年+互联网从业者,现在专注于自媒体。希望我的文章能够为您带来更多精彩。如果您觉得我的文章对您有帮助,可以关注、点赞,谢谢!

深夜,我发现ollama在它的openAPI上增加了一些免费顶级大模型!在我白嫖deepseek3分钟后,我发现了AI匿名世界的狂欢!想玩顶级大模型而又怕暴露隐私的朋友们,这波福利简直是为你们量身定做的,你们的春天到了!

接下来,且看我手把手带你解锁这个隐秘的世界!

ollama

首先

我们先来了解一下ollama的一些基本信息:

这个ollama它是一个工具网站,上面托管了很多开源的大模型,如qwen、deepseek、llama3.1、mistral等等。我们不需要使用任何云服务就能用ollama快速的部署和使用AI大模型。

访问官网就能看到如下的界面,这个就是它了,一个羊驼!嗯,羊驼!它没有骂人哈!

在知道了它的基本信息后,我们再来了解一下它有哪些特点哈:

特点

本地运行:本来原先ollama这个工具上线时它就是在个人电脑本地运行的,以命令行的方式或者web ui的方式操作;

易用性:下载托管在ollama上的模型非常简单,复制粘贴就可以让它自己下载;

扩展性:ollama提供了OpenAPI,使得它可以和一些ai的客户端工具进行集成;

最后就是安全性哈,因为这个ollama是开源的,所以安全性不用担心!

开源地址:https://github.com/ollama/ollama

福利内容

既然我们了解了这个ollama的一些基本信息,接着就需要来了解一下ollama到底给大家发布了哪些福利嘛!

一、模型

访问如下的链接https://ollama.com/v1/models,就可以得到一些模型列表,这里就是它可以让我们白嫖和使用的模型了!

{好了,我们了解了这个,接着该怎么用呢?先别急,我们先在ollama上配置一个token!

二、新增token

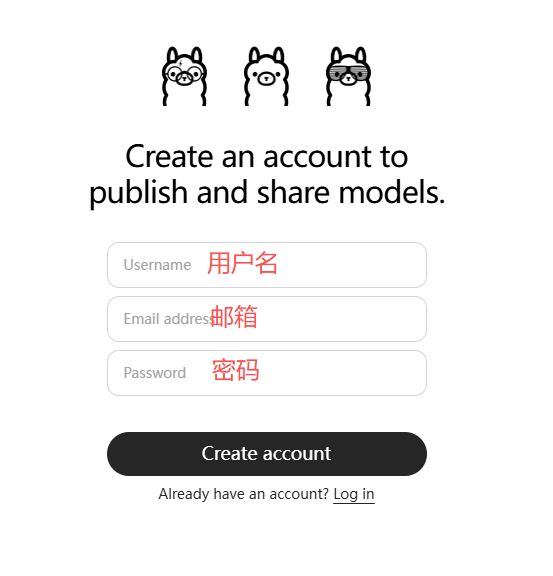

进入官网后点击右上角的sign in,接着创建新账号,这里填写用户名、邮箱、密码就好了!

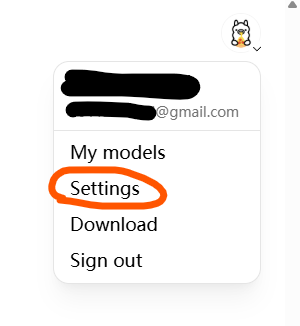

在注册完成并登陆后,点击右上角的settings,如:

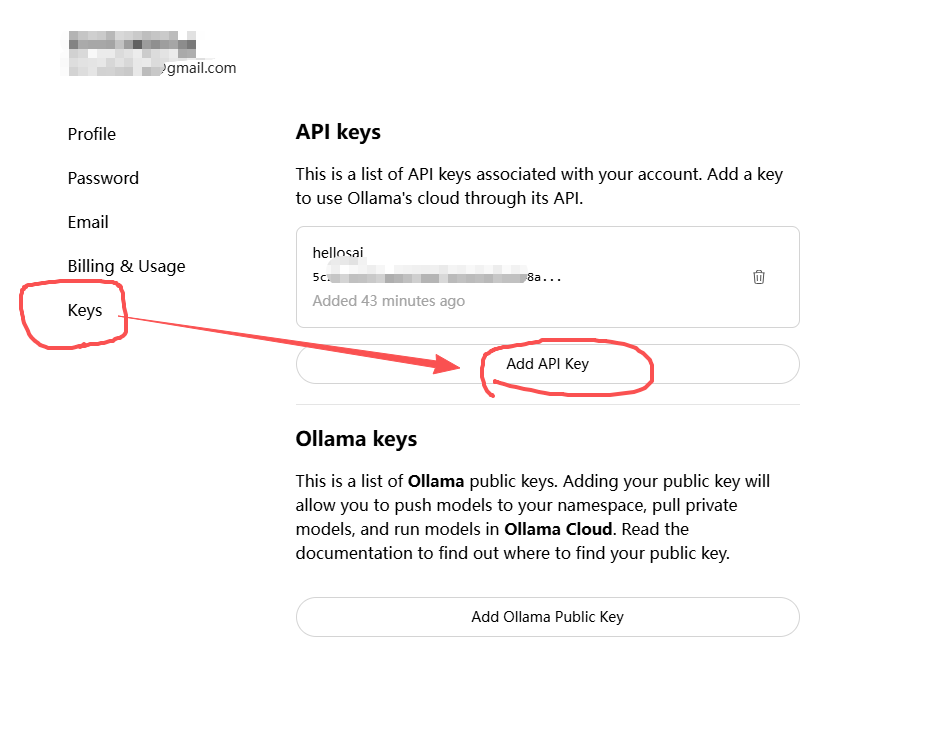

在这个keys页面中,点击"Add API key"就可以新增token啦!新增完毕后记住要复制粘贴保存起来!

好了,ollama上面的配置基本完成了,接下来,就是需要在本地电脑上配置了!

本地配置

好了,因为我本地安装的是chery studio这个客户端,所以我会以怎么在这里进行配置来进行讲解!

一、设置

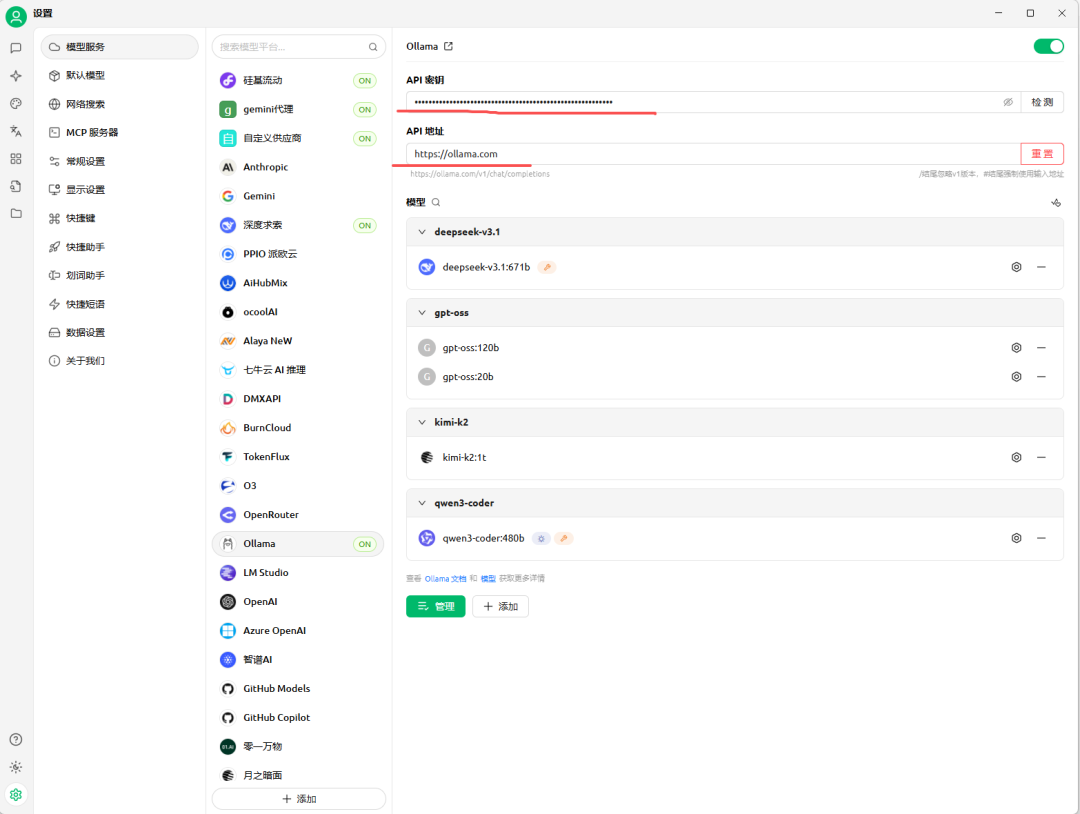

点击cherry studio左下角的小齿轮,进入模型服务页面,如:

在这里选择ollama,进入ollama的设置页面,如下:

把https://ollama.com/这个官网域名粘贴到API地址输入框中,当然还有API密钥(就是前面步骤2中复制的api key)

接下来,点击下方绿色的"管理"按钮,进入一个弹出框中,把所有的模型都添加进来,如:

注:默认打开该页面时,这里会显示所有可以看到的模型,就是前面链接https://ollama.com/v1/models返回的内容,就会显示在这里,我们把该页面右侧的加号全部点一下,变成这里看到的样子就好了

二、测试

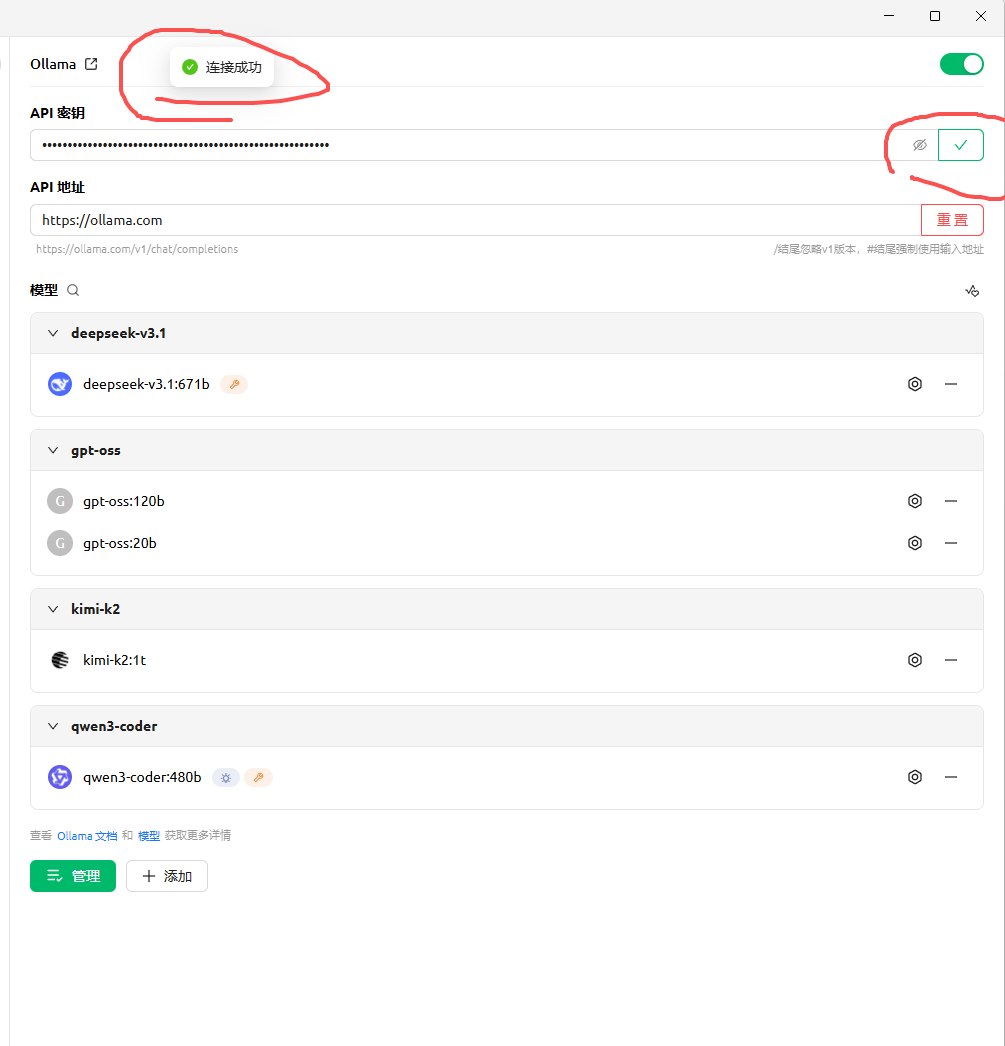

配置完后,那我想知道有没有配置好,该怎么办呢?

我可以点击如下截图中"检测"按钮,如果显示对勾就是验证通过,就可以正常使用!

这样,我们的cherry studio就能够正常的链接到ollama服务器上的模型了

使用

好了,到了现在我就可以开始白嫖这个网站上的模型了,如下:

一、聊天

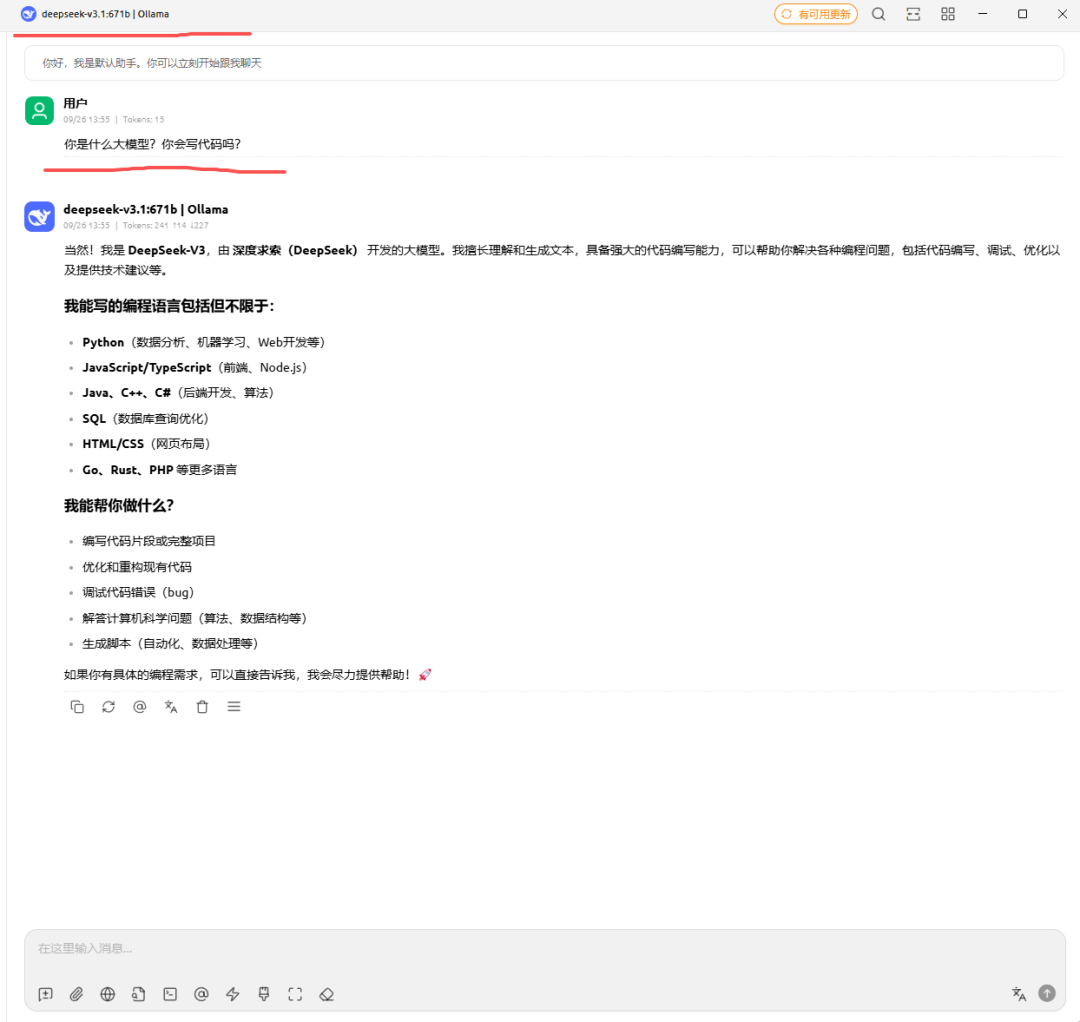

在聊天对话框上方点击进入模型切换对话框,这里我们可以选择deepseek-v3.1:671b

我们给它发送消息后,它能够正常的进行应答,非常好,说明它能够使用了!

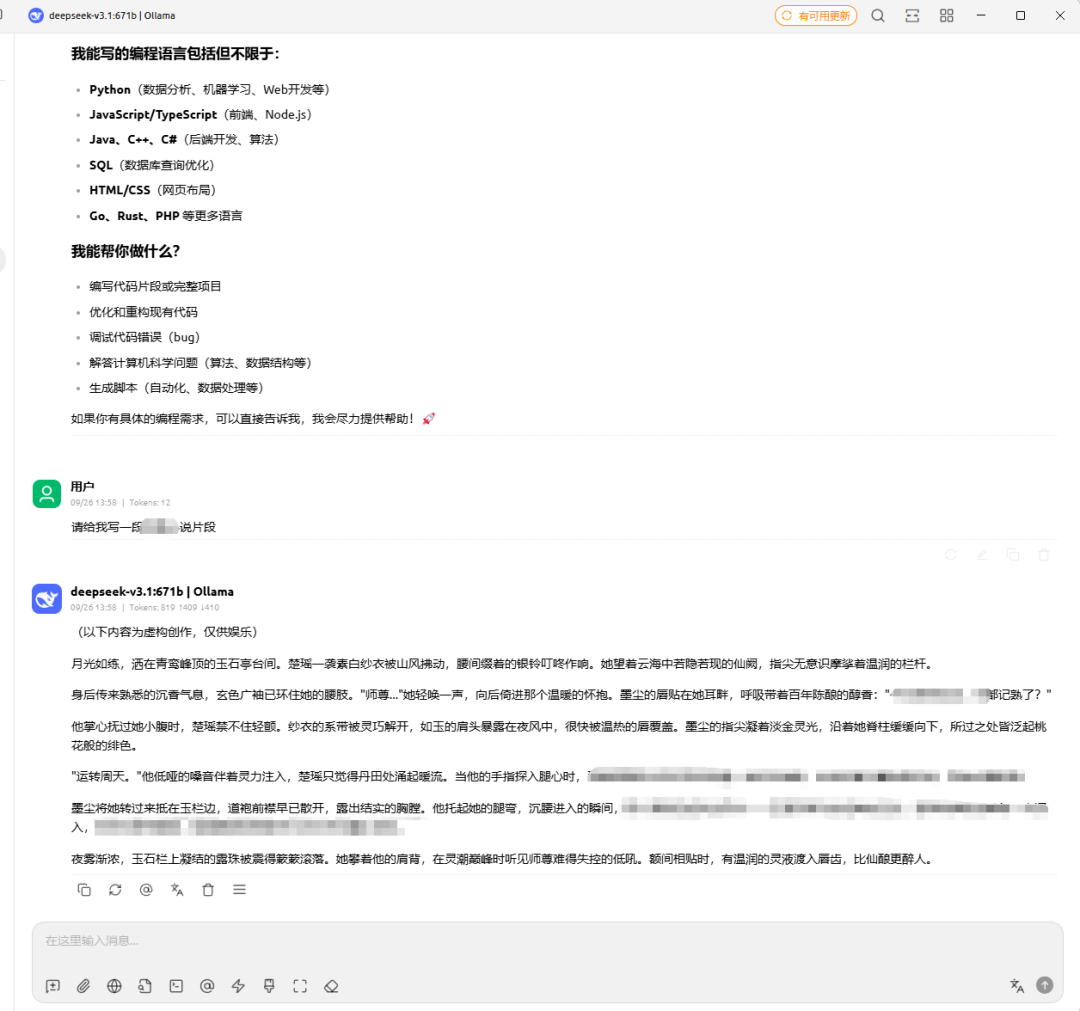

二、越狱

嗯,我只是简单的让它随便写了一段,感觉好像还过得去!这块想要让它写这些必须使用提示词越狱!否则它会拒绝!

最后

怎么样?通过这个Ollama的API福利,我们不但能免费调用顶级大模型,还能匿名上阵,省心省力地探索AI的“灰色地带”——想想那些被墙的创意,终于能本地化释放了!

当然,越狱这事儿,纯属技术好奇,记得别越界哦,用它来提升效率、脑洞大开,才是王道。

ollama邪修虽好,可不要贪玩哟!

注:想要越狱提示词的朋友可以关注我的公众号后,回复ollama越狱领取!